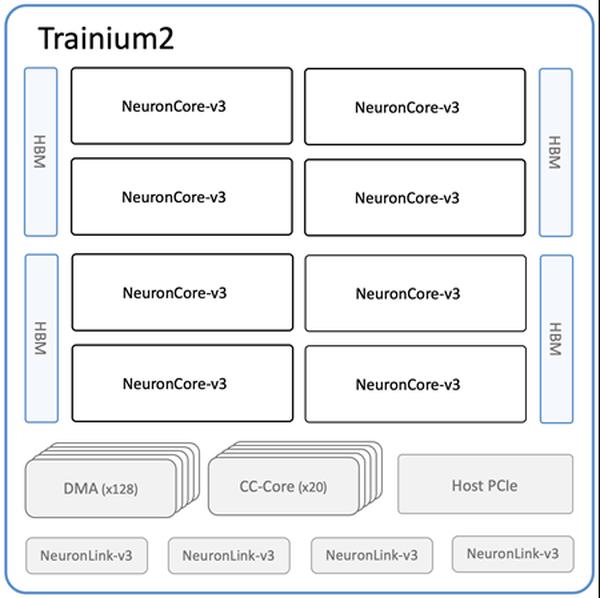

Amazon объявила о доступности новых инстансов Amazon EC2 Trn2 и Trn2 UltraServers, самых мощных вычислительных опций EC2 для обучения и инференса моделей машинного обучения (ML). Основанные на втором поколении чипов AWS Trainium (AWS Trainium2), инстансы Trn2 в 4 раза быстрее, имеют в 4 раза большую пропускную способность памяти и в 3 раза большую емкость памяти по сравнению с инстансами Trn1 первого поколения. Они предлагают на 30-40% лучшую ценовую производительность по сравнению с инстансами EC2 P5e и P5en текущего поколения на базе GPU. Каждый инстанс Trn2 оснащен 16 чипами Trainium2, 192 vCPU, 2 ТиБ памяти и пропускной способностью сети 3,2 Тбит/с с адаптером Elastic Fabric Adapter (EFA) v3 с задержкой до 50% меньше. Trn2 UltraServers, новое предложение, оснащены 64 чипами Trainium2, соединенными высокоскоростным соединением NeuronLink с низкой задержкой, для максимальной производительности на передовых фундаментальных моделях. Десятки тысяч чипов Trainium уже используются в сервисах Amazon и AWS. Более 80 000 чипов AWS Inferentia и Trainium1 поддерживали работу торгового помощника Rufus в Prime Day. Чипы Trainium2 уже используются в версиях моделей Llama 3.1 405B и Claude 3.5 Haiku, оптимизированных для низкой задержки, на Amazon Bedrock. Инстансы Trn2 доступны в регионе Восточное побережье США (Огайо) и могут быть зарезервированы с помощью блоков емкости Amazon EC2 для ML. Разработчики могут использовать AWS Deep Learning AMI, предварительно настроенные с такими фреймворками, как PyTorch и JAX. Существующие приложения AWS Neuron SDK можно перекомпилировать для Trn2. SDK интегрируется с JAX, PyTorch и библиотеками, такими как Hugging Face, PyTorch Lightning и NeMo. Neuron включает оптимизации для распределенного обучения и инференса с NxD Training и NxD Inference и поддерживает OpenXLA, позволяя разработчикам PyTorch/XLA и JAX использовать оптимизации компилятора Neuron.

Инстансы Amazon EC2 Trn2 и Trn2 UltraServers теперь доступны для обучения и инференса ИИ/МО

AWS